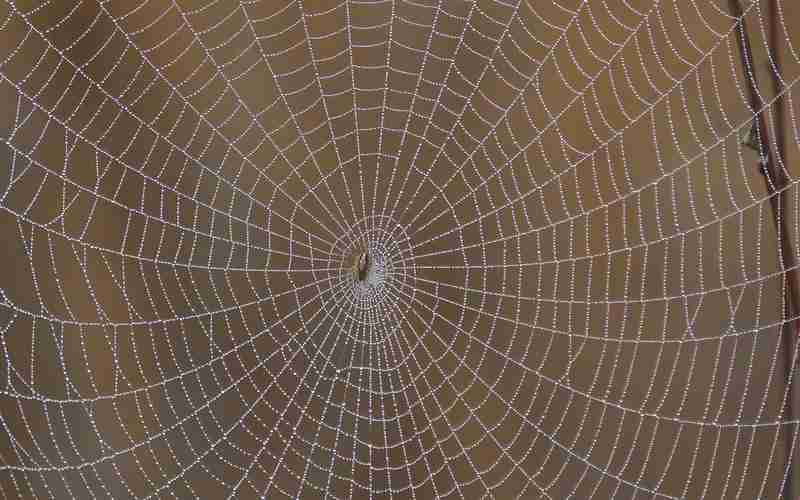

1. 控制搜索引擎爬取行为:通过合理设置robots.txt文件,网站管理员可以指导搜索引擎爬虫(如Googlebot)哪些页面可以被抓取,哪些页面不应被抓取。这有助于优化网站的抓取效率,避免重复内容的产生,从而提高网站在搜索引擎中的排名。

2. 保护隐私和安全:robots.txt文件可以防止搜索引擎抓取敏感信息或非公开内容,如后台、数据库文件、模板等,从而保护网站的隐私和安全。

3. 提高用户体验:通过阻止无关内容的抓取,robots.txt可以帮助减少服务器负载,提升网站的响应速度和用户体验。

4. 优化SEO效果:合理的robots.txt设置可以确保搜索引擎优先抓取重要的页面,同时避免浪费爬虫资源在不重要的页面上。通过指定爬取延迟(Crawl-delay),可以避免服务器过载。

5. 避免SEO作弊:如果robots.txt设置不合理或存在漏洞,可能会被搜索引擎视为SEO作弊行为,从而影响网站的排名。

6. 标准化和行业认可:robots.txt作为国际互联网界通行的道德规范,已被广泛接受和使用。谷歌等主流搜索引擎均遵循该协议,因此正确使用robots.txt有助于确保网站被搜索引擎正确识别和索引。

robots.txt在谷歌SEO中扮演着关键角色,通过合理配置,不仅可以提升网站的SEO效果,还能保护网站的安全性和用户体验。